Come funzionano i motori di ricerca

April 05, 2018

Ti sei mai chiesto quante volte al giorno usi Google o un altro motore di ricerca?

5 volte, 10 volte o a volte anche di più? Sai che Google, da solo, gestisce 2 bilioni di ricerche all’anno?

I numeri parlano chiaro, i motori di ricerca sono diventati parte integrante della nostra quotidianità.

Perché? Perché sappiamo che i motori di ricerca, e soprattutto Google, hanno la risposta a quasi tutti i nostri dubbi.

Ma come funzionano i motori di ricerca?

Qual è il motore di ricerca più usato in Italia?

Statistica aggiornata al 2018, fonte gs.statcounter.com

Come funzionano i motori di ricerca?

I motori di ricerca sono complessi programmi computer.

La prima fase è il processo di ricerca delle informazioni, la seconda fase consiste nell’organizzare le informazioni trovate così da renderle utilizzabili successivamente nella ricerca. Questo processo è noto, nel mondo dell’internet, come Crawling e Indicizzazione.

Crawling

I motori di ricerca hanno dei programmi computer chiamati crawlers, che hanno la responsabilità di trovare le informazioni pubbliche sul web.

Per semplificare un processo in realtà molto complicato, il lavoro dei crawlers è quello di scansionare il web e trovare i server (o webserver) che ospitano i siti internet.

Perché è importante conoscere questo processo?

La tua prima preoccupazione, nell’ottimizzare un sito per i motori di ricerca, è essere sicuro che possa essere visto correttamente da crawlers, ecco come:

- Usare un file Robots.txt per specificare quali pagine del tuo sito web non vuoi che vedano. Per esempio la tua pagina Admin e altre pagine che non devono essere pubbliche sul web.

- Usa una xml sitemap per elencare tutte le pagine importanti del tuo sito così gli spider sapranno quali pagine monitorare per cambiamenti e quali ignorare.

Indicizzazione

Per costruire un motore di ricerca serve anche una seconda fase, chiamata indicizzazione. Le informazioni raccolte devono infatti essere organizzate, ordinate per categoria e immagazzinate prima di essere messe a disposizione dell’utente finale.

I motori di ricerca non immagazzinano tutte le informazioni nel loro indice, ma tengono tutti i parametri che servono gli algoritmi.

Perché è importante conoscere questo processo?

È molto semplice, se il tuo sito internet non è nell’indice, allora non apparirà per nessuna ricerca. Questo significa anche che più pagine hai nell’indice, più sono le probabilità che tu appaia quando qualcuno cerca specifiche parole connesse ai titoli e contenuti delle tue pagine. Ovviamente non è detto che appaia subito in prima posizione, ne nella prima pagina.

Gli algoritmi dei Motori di Ricerca

Il terzo e ultimo step nel processo è quello per “scegliere” quali pagine mostrare nei risultati di ricerca e in quale ordine. Questo è fatto tramite degli algoritmi , che sono frazioni di software che hanno un numero di regole tramite le quali analizzano quello che l’utilizzatore chiede e cosa proporgli in risposta.

Ecco un esempio, molto semplificato, del processo di funzionamento di questi algoritmi:

1) Il primo step è capire che tipo di informazione l’utente sta cercando, oggi questo è fatto spezzettando la ricerca dell’utente in tante keyword.

2) Il secondo step è trovare, nel loro indice, pagine che corrispondono a quello che l’utente ha cercato.

Gli updates di Google e come hanno influito sulla ricerca

Ci sono stati 4 maggiori aggiornamenti di Google, che come abbiamo detto è il motore di ricerca più utilizzato: Panda, Penguin, Hummingbird e l’Index Mobile First.

GOOGLE PANDA

Panda è un’aggiornamento dell’algoritmo di Google che mira a migliorare il posizionamento delle pagine che hanno dei contenuti di qualità. è stato introdotto in Italia nel 2012 e nel 2016 è stato integrato nel “Core Ranking Algorithm” ovvero nell’algoritmo principale di Google.

Vengono inoltre penalizzati i siti che:

- Sono poco affidabili

- Hanno molti annunci pubblicitari e poco contenuto originale

- Contenuti che non sono coerenti con le query di ricerca per cui cercano di posizionarsi, ad esempio pagine che hanno come titolo “Coupon per supermercati” e che quando clicchi all’interno non hanno nessun coupon ma solo pubblicità.

- Hanno dei contenuti nascosti (Cloacking)

GOOGLE PENGUIN

Penguin è un’aggiornamento dell’algoritmo che mira, sulla scia di Panda, a migliorare il posizionamento dei siti internet di qualità, penalizzando o peggiorando il posizionamento dei siti che fanno schemi di link e keyword stuffing. Agli inizi del 2017 è stato reso parte dell’algoritmo principale di Google.

GOOGLE HUMMINGBIRD

Al contrario di Panda e Penguin, che erano aggiunte all’algoritmo di Google, Hummingbird è stato definito una “rivoluzione” dell’algoritmo di ricerca. Hummingbird non è stato creato per penalizzare i siti web che cercavano di manipolare Google, ma per rendere la ricerca più intelligente.

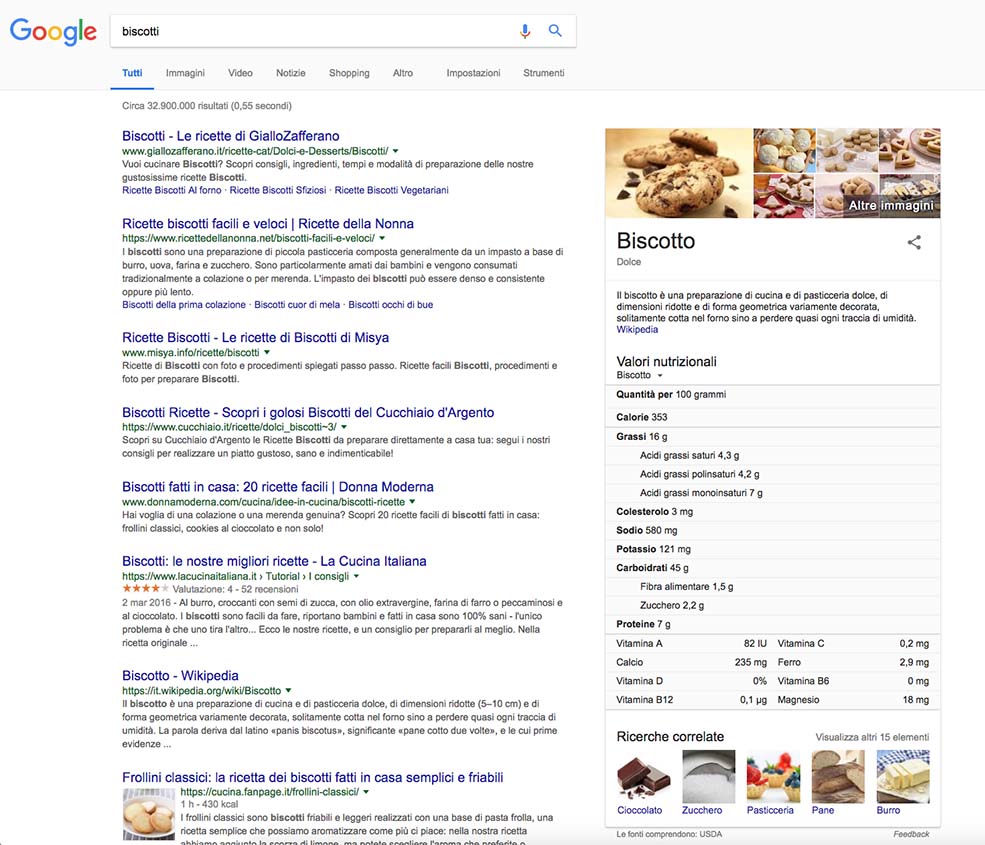

Che cosa significa? Google ha sviluppato, per facilitare la ricerca, una sidebar che compare a destra dei risultati di ricerca, possiamo vederlo cercando la query “biscotti”. Di lato vengono mostrati i valori nutrizionali, una definizione e alcune ricerche correlate.

Ma come riesce un motore di ricerca a comprendere l’intento dell’utente e mostrare i risultati rilevanti, anche quando l’intento della ricerca non è esplicito?

Con la Ricerca Semantica. La ricerca semantica infatti cerca di mostrare SERP appropriate alla ricerca degli utenti andando oltre il significato si ogni singola parola chiave.

Mobile First Index

Questo aggiornamento, di cui si è parlato per tutto l’anno scorso, e che è finalmente pronto a diffondersi su scala mondiale, è un’aggiornamento che interessa il modo in cui Google indicizza le pagine web.

I web crawler di Google, infatti, hanno sempre guardato prima l’aspetto e l’usabilità del sito desktop e poi il sito smartphone. Da adesso sarà il contrario: verrà prima visto il sito mobile, poi si la versione desktop.

La tua Web Agency a Brescia

Vuoi ottimizzare il tuo sito web per posizionarti sui motori di rcierca?. Inviaci una mail per fare una chiacchierata.

Invia una email

Autore: